MultiSenseLakePerceptor: Optisches Multisensorsystem für autonome Anwendungen auf Binnengewässern

In der Schifffahrt besteht derzeit ein intensives Bestreben, die  Sicherheit durch Automatisierung deutlich zu erhöhen. Unfallstatistiken der Wasserschutzpolizei am Bodensee belegen, dass gerade auf Binnenseen und im Küstenbereich die Zahl der durch Unachtsamkeit verursachten Unfälle bisher unverändert hoch ist. In der Komplexität sind die Verkehrsszenarien auf Binnenseen denen im Straßenverkehr durchaus vergleichbar, zeichnen sich aber durch eine Vielzahl von Besonderheiten aus. So gibt es eine eindeutige Spurführung nur vereinzelt in Ufernähe, Manöver anderer Verkehrsteilnehmer sind häufig schwer abschätzbar bzw. vorhersagbar. Den Verkehrsraum teilen sich verschiedenste Wasser-Fahrzeugtypen, inklusive schwimmender Personen. Gleichzeitig erschwert die durch den Wellenschlag verursachte Eigenbewegung der Sensorplattform eine Interpretation der aktuellen Verkehrs- und damit auch die Einschätzung der Gefahrenlage. Um ganz oder teilweise autonom operierende Wasserfahrzeuge realisieren zu können, ist insbesondere die zuverlässige, detaillierte und über weite Distanzen reichende Aufnahme der aktuellen Szene sowie die robuste Zustandsschätzung und Klassifikation von Objekten von erheblicher Bedeutung. Die Problematik der Objektdetektion sowie des Objekttrackings wird innerhalb des Projekts durch die Entwicklung eines optischen Multisensorsystems durch ein interdisziplinäres Team (siehe Abbildung 1), bestehend aus Mitarbeitern des Instituts für optische Systeme und des Instituts für Systemdynamik, angegangen.

Sicherheit durch Automatisierung deutlich zu erhöhen. Unfallstatistiken der Wasserschutzpolizei am Bodensee belegen, dass gerade auf Binnenseen und im Küstenbereich die Zahl der durch Unachtsamkeit verursachten Unfälle bisher unverändert hoch ist. In der Komplexität sind die Verkehrsszenarien auf Binnenseen denen im Straßenverkehr durchaus vergleichbar, zeichnen sich aber durch eine Vielzahl von Besonderheiten aus. So gibt es eine eindeutige Spurführung nur vereinzelt in Ufernähe, Manöver anderer Verkehrsteilnehmer sind häufig schwer abschätzbar bzw. vorhersagbar. Den Verkehrsraum teilen sich verschiedenste Wasser-Fahrzeugtypen, inklusive schwimmender Personen. Gleichzeitig erschwert die durch den Wellenschlag verursachte Eigenbewegung der Sensorplattform eine Interpretation der aktuellen Verkehrs- und damit auch die Einschätzung der Gefahrenlage. Um ganz oder teilweise autonom operierende Wasserfahrzeuge realisieren zu können, ist insbesondere die zuverlässige, detaillierte und über weite Distanzen reichende Aufnahme der aktuellen Szene sowie die robuste Zustandsschätzung und Klassifikation von Objekten von erheblicher Bedeutung. Die Problematik der Objektdetektion sowie des Objekttrackings wird innerhalb des Projekts durch die Entwicklung eines optischen Multisensorsystems durch ein interdisziplinäres Team (siehe Abbildung 1), bestehend aus Mitarbeitern des Instituts für optische Systeme und des Instituts für Systemdynamik, angegangen.

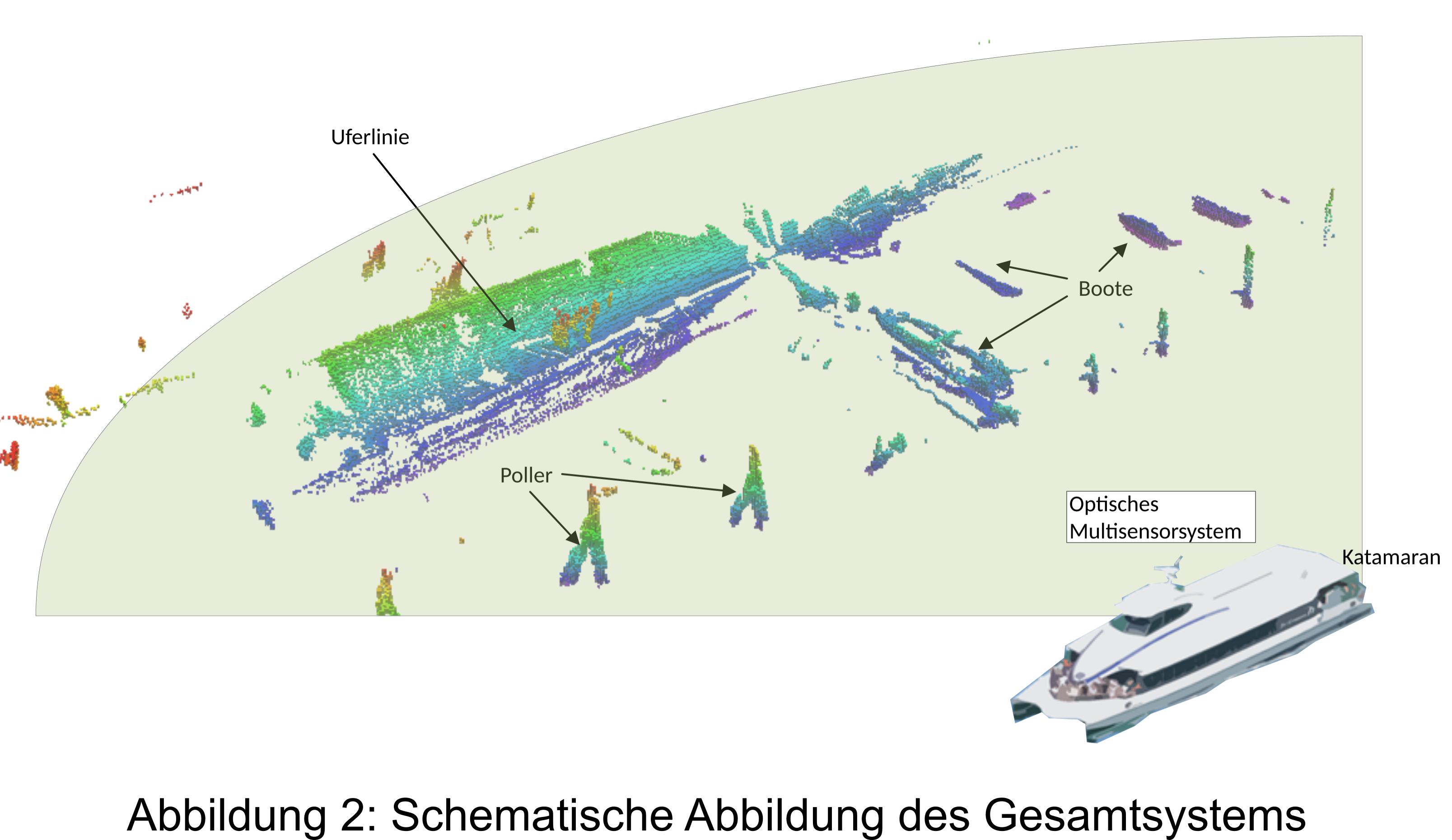

Im Rahmen des Projekts soll die Problemstellung mit optischen Sensoren verbunden mit Lidar gelöst werden. Durch Vernetzung unterschiedlicher Sensortypen wird ein geeignetes Abbild der komplexen dynamischen 3D-Szene erstellt (siehe Abbildung 2) und dieses dann Tracking- und Klassifikationsalgorithmen zur Verfügung gestellt. Die sensorspezifischen 3D-Punktwolken sind zu diesem Zeitpunkt weder zueinander registriert noch fusioniert. Zur Schätzung der einzelnen Tiefenkarten und Objektlisten mittels Machine-Learning, wird innerhalb des Projekts eine neuartige Deep-Learning Architektur entwickelt. Im Vergleich zu heutigen Convolutional Neural Networks muss diese mit den für 3D-Punktwolken typischen Messpunkten ohne feste Nachbarschaftsbeziehungen zurechtkommen. Die Fusion erfolgt erst im nächsten Schritt, wodurch sich das Multisensorsystem modular aufbauen lässt. Dies ermöglicht gleichzeitig eine sehr robuste Fusion der einzelnen Sensoren mittels Random-Finite-Set-Methoden auf Basis der durch das Netzwerk bereits stark vorverarbeiteten Einzelsensordaten. Über mehrere Zeitschritte hinweg wird so der kinematische Zustand der Objekte sowie deren Ausdehnung geschätzt und damit ein umfassendes Bild der Umgebung erzeugt. Dabei wird im Vergleich zu gängigen Methoden zusätzlich die Eigenbewegung des Bootes mittels Ego-Motion Kompensation berücksichtigt. Das im Rahmen des Projekts zu entwickelnde Sensorsystem zur autonomen 3D-Umfelderfassung auf Binnengewässern soll auf dem bereits existierenden autonomen Wasserfahrzeug „Solgenia“ installiert werden. Dabei sind zwei exemplarische Anwendungen zur Kollisionsvermeidung und automatisiertem Anlegen angestrebt.

Im Rahmen des Projekts soll die Problemstellung mit optischen Sensoren verbunden mit Lidar gelöst werden. Durch Vernetzung unterschiedlicher Sensortypen wird ein geeignetes Abbild der komplexen dynamischen 3D-Szene erstellt (siehe Abbildung 2) und dieses dann Tracking- und Klassifikationsalgorithmen zur Verfügung gestellt. Die sensorspezifischen 3D-Punktwolken sind zu diesem Zeitpunkt weder zueinander registriert noch fusioniert. Zur Schätzung der einzelnen Tiefenkarten und Objektlisten mittels Machine-Learning, wird innerhalb des Projekts eine neuartige Deep-Learning Architektur entwickelt. Im Vergleich zu heutigen Convolutional Neural Networks muss diese mit den für 3D-Punktwolken typischen Messpunkten ohne feste Nachbarschaftsbeziehungen zurechtkommen. Die Fusion erfolgt erst im nächsten Schritt, wodurch sich das Multisensorsystem modular aufbauen lässt. Dies ermöglicht gleichzeitig eine sehr robuste Fusion der einzelnen Sensoren mittels Random-Finite-Set-Methoden auf Basis der durch das Netzwerk bereits stark vorverarbeiteten Einzelsensordaten. Über mehrere Zeitschritte hinweg wird so der kinematische Zustand der Objekte sowie deren Ausdehnung geschätzt und damit ein umfassendes Bild der Umgebung erzeugt. Dabei wird im Vergleich zu gängigen Methoden zusätzlich die Eigenbewegung des Bootes mittels Ego-Motion Kompensation berücksichtigt. Das im Rahmen des Projekts zu entwickelnde Sensorsystem zur autonomen 3D-Umfelderfassung auf Binnengewässern soll auf dem bereits existierenden autonomen Wasserfahrzeug „Solgenia“ installiert werden. Dabei sind zwei exemplarische Anwendungen zur Kollisionsvermeidung und automatisiertem Anlegen angestrebt.

Das Projekt wird finanziert durch die Baden-Württemberg Stiftung gGmbH.

Assoziierte Partner:

- Katamaran-Reederei Bodensee GmbH & Co. KG

- ZF Friedrichshafen AG

- In-innovative navigation GmbH

- Robert Bosch GmbH